En el mundo digital actual, donde la información se encuentra dispersa por la web, surge una técnica fascinante: el scraping. Ya seas un usuario inquisitivo, una empresa en busca de una ventaja competitiva o un investigador ansioso por descubrir datos valiosos, el scraping ofrece la oportunidad de extraer y recopilar información relevante con un proceso ordenado y estructurado.

El scraping, también conocido como web scraping o web harvesting, es un proceso automatizado mediante el cual se extraen datos de páginas web u otras fuentes con un proceso ordenado y estructurado para extraer los datos. En lugar de realizar la extracción de forma aleatoria o manual, el scraping se lleva a cabo utilizando software especializado que sigue una serie de pasos predefinidos.

¿Con qué finalidad se suele usar el scraping?

El scraping se puede usar tanto con fines profesionales como personales. Por ejemplo, para uso personal te puede ayudar a comparar precios extrayendo datos de diferentes sitios web de comercio electrónico y comparando los precios para obtener el más barato. Puede monitorear noticias y tendencias recopilan información de múltiples fuentes, como sitios de noticias o redes sociales como Twitter, Facebook, etc. Otro uso interesante es el seguimiento de opiniones y reseñas ya que es útil conocer las opiniones de otros usuarios. Incluso te puede ayudar si estás realizando un proyecto de investigación, escribiendo un blog o simplemente recopilando información sobre un tema en particular, ya que puedes extraer datos relevantes de diversas fuentes para respaldar tu trabajo y obtener una visión más completa.

Y por supuesto el análisis de redes sociales, ya que con el scraping, puedes recopilar datos de perfiles, publicaciones y comentarios para realizar análisis de sentimiento, identificar patrones o descubrir nuevos temas de interés, como por ejemplo el Twitter Scraper.

En el ámbito profesional también tiene diversas utilidades y aplicaciones, como por ejemplo:

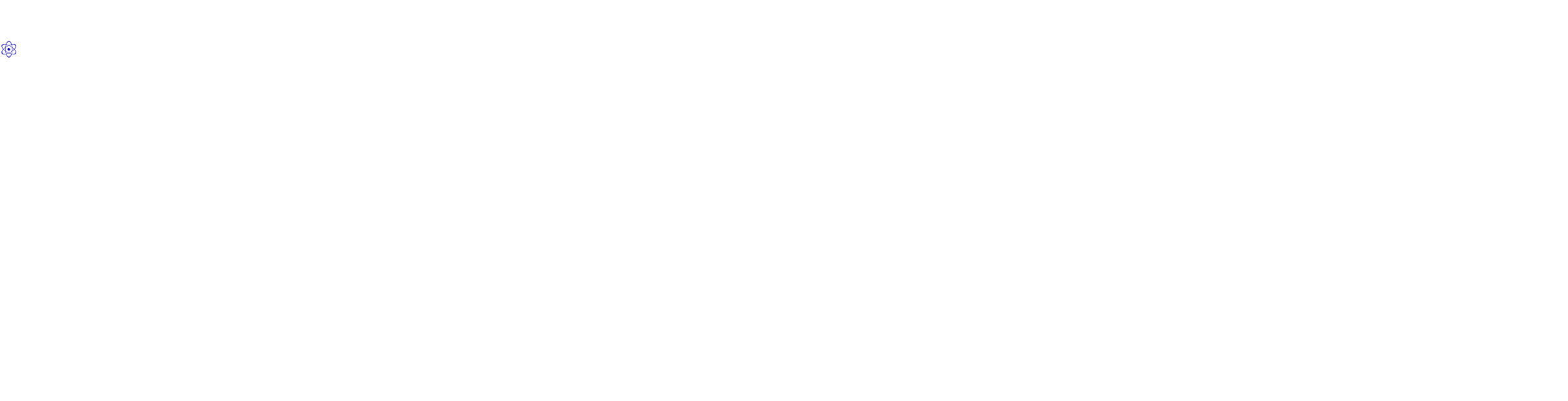

Obtener datos para análisis: permite recopilar grandes cantidades de datos de manera automatizada, lo que resulta útil para realizar análisis de mercado, seguimiento de tendencias, estudios de opinión, investigación académica y otros análisis cuantitativos.

Monitoreo competitivo: Las empresas pueden utilizar el scraping para recopilar información sobre sus competidores, como precios de productos, estrategias de marketing, reseñas de clientes, entre otros. Esto les proporciona una ventaja competitiva al tener una visión más completa del panorama del mercado.

Generación de leads: El scraping se puede emplear para extraer información de contactos comerciales, como direcciones de correo electrónico, números de teléfono y perfiles de redes sociales. Esto facilita la creación de listas de prospectos para campañas de marketing y ventas.

Personalización de servicios: Al recopilar datos sobre los usuarios, como sus preferencias y comportamientos en línea, las empresas pueden personalizar sus servicios y ofrecer recomendaciones más precisas. Esto se utiliza comúnmente en plataformas de comercio electrónico, redes sociales y servicios de streaming.

Seguimiento de contenido: El scraping puede ayudar a realizar un seguimiento de cambios en páginas web, como actualizaciones de precios, disponibilidad de productos o cambios en los términos y condiciones de los sitios. Esto es útil para realizar seguimiento de precios, recibir notificaciones de cambios o detectar modificaciones en contenido relevante.

Agregación de contenido: puede emplearse para recopilar y consolidar contenido de diferentes fuentes en un solo lugar. Esto se utiliza en sitios web de noticias, agregadores de contenido y motores de búsqueda, donde se recopila información de diversas fuentes para presentarla de manera organizada.

¿De donde obtiene la información el scraping?

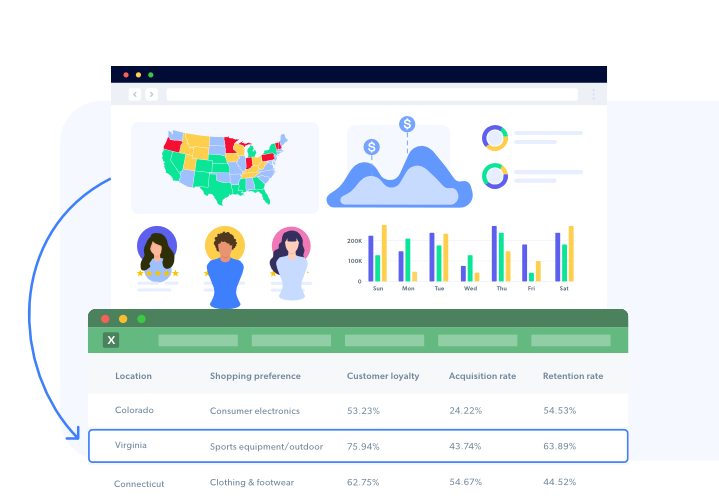

Las fuentes para el scraping son como los lugares donde se buscan los datos en Internet. Hay diferentes tipos de fuentes que podemos usar. Por ejemplo, tenemos los sitios web públicos, que son como esos blogs, noticias o foros que visitamos a diario. También están las APIs, que son como accesos directos a datos estructurados que nos ofrecen algunas empresas y plataformas. Además, están los datos gubernamentales, las paginas web o las redes sociales, como por ejemplo Twitter. La elección de la mejor opción depende del objetivo específico de la extracción de datos.

Los tipos de fuentes de datos comunes utilizados en el scraping son:

- Sitios web públicos: Los sitios web públicos son una fuente popular para el scraping. Puedes extraer datos de páginas web de noticias, blogs, foros y otros sitios accesibles públicamente.

- APIs: Muchas empresas y plataformas ofrecen APIs (Interfaces de Programación de Aplicaciones) que permiten acceder a datos estructurados de manera más directa y legítima. Estas APIs a menudo tienen limitaciones de acceso, pero proporcionan datos actualizados y confiables.

- Datos gubernamentales: Los gobiernos de diferentes países suelen proporcionar una gran cantidad de datos públicos, como estadísticas demográficas, informes económicos, datos climáticos y registros legales. Estos conjuntos de datos pueden ser valiosos para investigaciones académicas, análisis de mercado y aplicaciones relacionadas con políticas públicas.

- Datos de comercio electrónico: Muchas plataformas de comercio electrónico tienen APIs o estructuras de datos accesibles que permiten extraer información sobre productos, precios, reseñas y más. Esto es especialmente útil para el monitoreo competitivo, análisis de precios y estudios de mercado.

- Redes sociales: Las redes sociales también son una fuente importante de datos para el scraping. Puedes obtener información de perfiles de usuarios, publicaciones, comentarios y tendencias en plataformas como Twitter, Facebook, Instagram y LinkedIn. El scraping de redes sociales puede ser valioso para el análisis de sentimiento, la detección de tendencias y la comprensión del comportamiento de los usuarios.

- Fuentes de datos científicos: Existen bases de datos y repositorios en línea que almacenan datos científicos, como artículos de investigación, conjuntos de datos genómicos, información sobre medicamentos, entre otros. Estas fuentes pueden ser valiosas para investigaciones académicas y científicas.

Así funciona el scraping

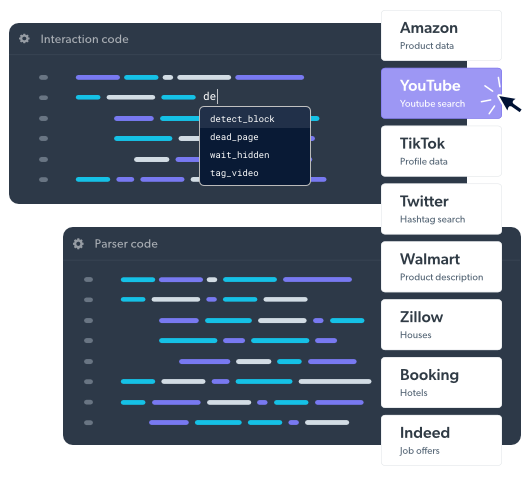

Estos son los pasos involucrados en el proceso de scraping:

- Obtención de la URL: El primer paso es proporcionar al scraper la dirección URL del sitio web que se desea analizar. Esta URL es como la dirección de una casa en Internet.

- Solicitudes HTTP: Una vez que se tiene la URL, el scraper envía solicitudes HTTP al servidor que aloja el sitio web. Estas solicitudes pueden ser del tipo GET o POST, dependiendo de la interacción requerida. Al enviar la solicitud, el scraper «llama» a la página web y solicita su contenido.

- Recepción del código fuente: El servidor del sitio web recibe la solicitud y envía como respuesta el código fuente de la página. El código fuente está compuesto principalmente por HTML, que define la estructura y el contenido de la página, junto con CSS y JavaScript, que se encargan de la presentación y la interactividad.

- Análisis del código fuente: Una vez que el scraper recibe el código fuente, lo analiza en busca de los elementos y datos específicos que se desean extraer. Esto se hace utilizando técnicas de parsing, que permiten «desglosar» el código y acceder a sus diferentes partes. Por ejemplo, el scraper puede buscar etiquetas HTML específicas, clases CSS o atributos para identificar la ubicación de los datos deseados.

- Extracción de datos: Una vez que se identifican los elementos y datos objetivo, el scraper extrae la información relevante. Esto puede incluir texto, imágenes, enlaces, datos tabulares u otros elementos presentes en la página web. Para realizar esta extracción, se utilizan técnicas como XPath, que permite navegar y seleccionar elementos en documentos XML/HTML, o CSS selectors, que permiten seleccionar elementos utilizando sintaxis similar a la de los estilos CSS.

- Almacenamiento de datos: Los datos extraídos se almacenan en un formato estructurado, como un archivo CSV, JSON o una base de datos. Esto permite organizar y gestionar los datos obtenidos para su posterior uso en análisis, visualización u otras aplicaciones.

Aunque pueda parecer un procedimiento complicado, existen herramientas online que se encarga de toso este proceso facilitando al usuario la obtención de los datos que desea. Puedes ver un ejemplo de como se obtienen datos de Twitter con Twitter Scraper.

Algunos sitios web pueden tener políticas en contra del scraping o limitar el acceso a través de técnicas como CAPTCHAs o bloqueo de IP. En tales casos, pueden ser necesarios enfoques adicionales, como el uso de proxies (servidores intermediarios) para ocultar la identidad del scraper, o el uso de OCR (reconocimiento óptico de caracteres) para resolver los desafíos CAPTCHA.